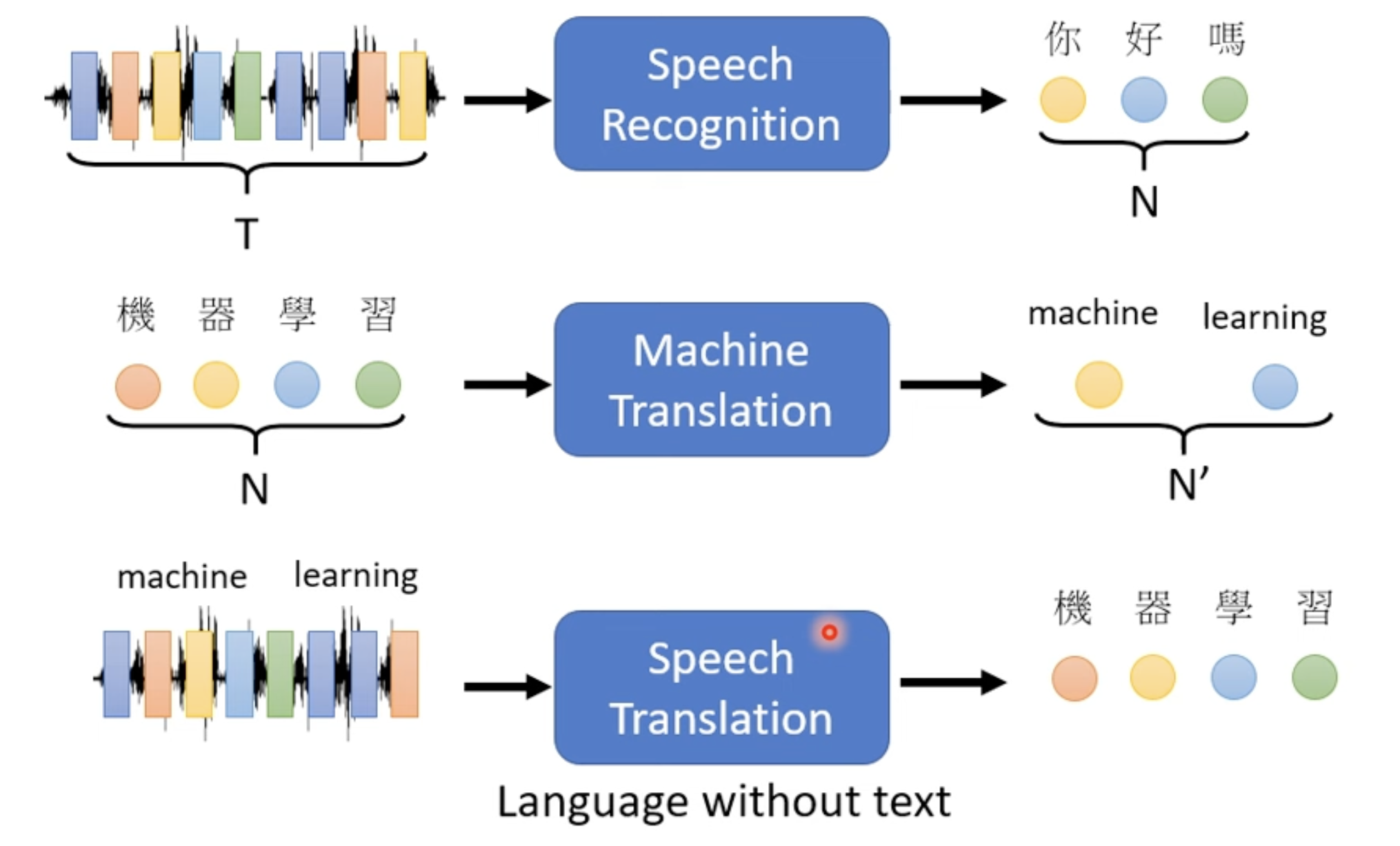

之前的输入全部是以一个向量作为输入,如何处理输入是一排不定数量的向量呢?

文字输入句子,语音信号,关系图(人际关系,分子结构)

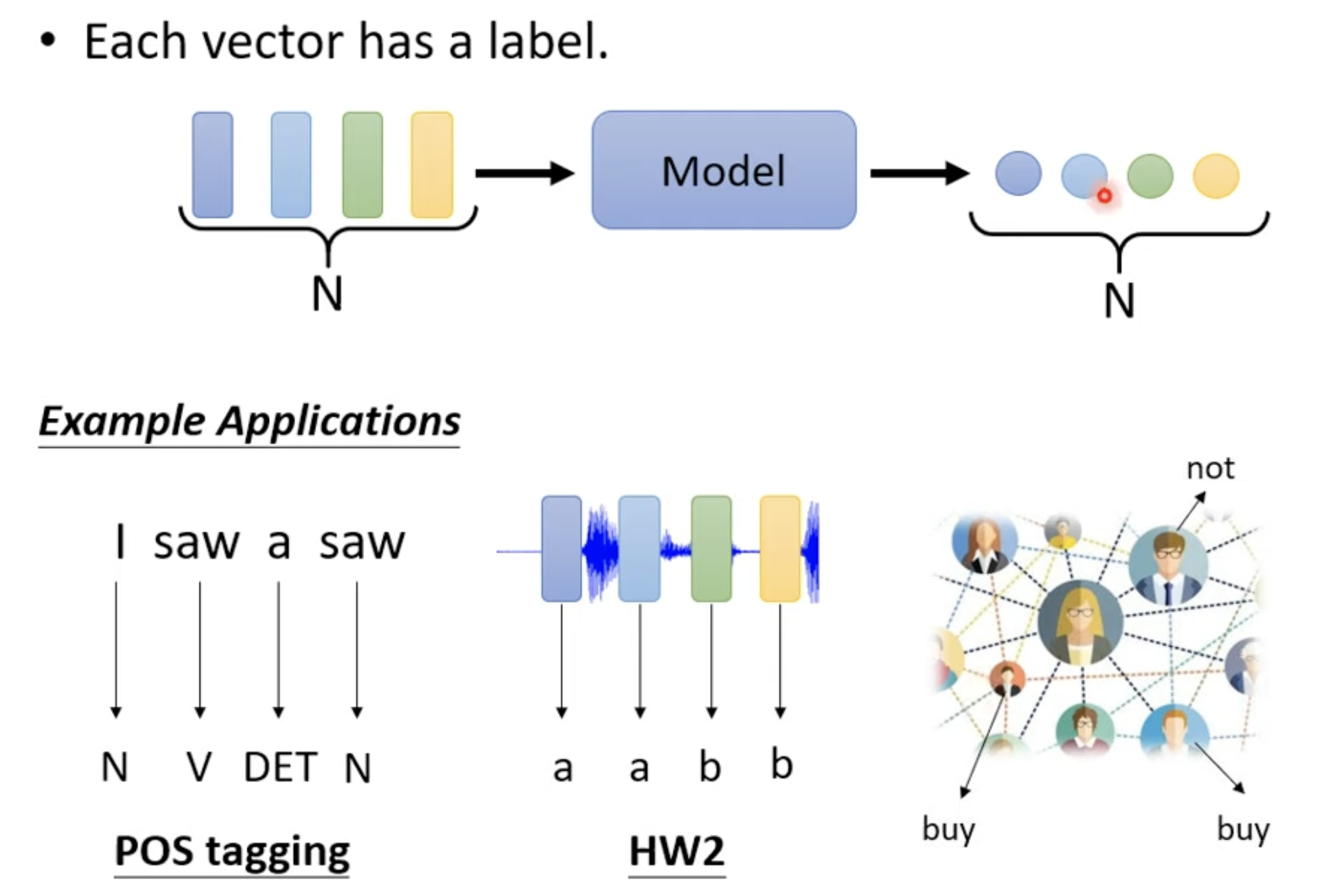

- Each vector has a label (label: value type for regression problem, class type for classification problem)

- 应用: 分析文字的词性,分析声音信号里面的 phonetic,分析 social network 中每个节点的特性,比如电商环境里面分析某个人会不会购买某个商品。